Les théoriciens qui, les premiers, ont élaboré les mathématiques décrivant le comportement du "manteau d'invisibilité" récemment annoncé (voir notre news) viennent de publier une nouvelle analyse mathématique qui pourrait étendre les pouvoirs du manteau actuel, lui permettant même de rendre invisible des objets actifs émettant un rayonnement comme un téléphone cellulaire ou une lampe-torche.

La nouvelle théorie mathématique d'Allan Greenleaf, professeur de mathématiques à l'université de Rochester, prévoit certains phénomènes étranges à l'intérieur du manteau. Et c'est justement ce qui se passe à l'intérieur qui est crucial pour l'efficacité du procédé.

En octobre, David R. Smith, professeur en génie informatique et électrique à l'université Duke, avait utilisé un dispositif circulaire courbant les micro-ondes autour d'un disque de cuivre, rendant celui-ci invisible pour ces longueurs d'onde. En 2003, cependant, Greenleaf et ses collègues avait déjà développé des mathématiques de l'invisibilité, appliquées au domaine médical (la détection de tumeurs).

L'été dernier, Greenleaf et ses collègues ont pris connaissance de l'article sur les travaux des chercheurs de Duke et de l'Imperial College paru dans la revue Science, qui utilisaient des équations presque identiques pour leur dispositif d'invisibilité. Greenleaf s'est aperçu que ses propres résultats pouvaient également être utilisés pour "cacher" un objet, et lui et son équipe ont décidé d'analyser et d'améliorer le dispositif de dissimulation proposé, en utilisant les techniques qu'ils avaient développées dans leurs premiers travaux. Pour eux, la question cruciale était: que se passe-t-il à l'intérieur de la région masquée ?

Smith, physicien, savait décrire pourquoi le dispositif de dissimulation fonctionnait. Greenleaf, mathématicien, savait que pour avoir une chance de l'étendre et de l'améliorer, il était important de comprendre entièrement les mathématiques sous-jacentes au phénomène. La publication en octobre, par Smith, de la description du dispositif réel a rendu encore plus cruciale la nécessité d'une analyse soigneuse de ses structures fondamentales.

Greenleaf et ses collaborateurs ont utilisé des mathématiques sophistiquées pour comprendre ce qu'il devait se passer à l'intérieur de la région masquée. Tout semblait très bien se dérouler tant qu'était appliquée l'équation de Helmholtz, équation largement répandue pour résoudre des problèmes concernant la propagation de la lumière. Mais lors de l'utilisation des équations de Maxwell, qui tiennent compte de la polarisation des ondes électromagnétiques, les difficultés ont émergé.

Les équations de Maxwell indiquaient qu'un disque de cuivre simple comme celui que Smith avait utilisé pouvait être masqué sans problème, mais pour un objet émettant des ondes électromagnétiques tel un téléphone cellulaire, une montre digitale, ou même un dispositif électrique simple comme une lampe torche, le comportement du dispositif de dissimulation devenait des plus étranges. Les mathématiques prévoyaient que les champs électromagnétiques devaient atteindre des valeurs infinies à la surface de la région masquée, ce qui, probablement, remettrait en cause l'invisibilité.

L'analyse a également révélé une autre surprise: une personne essayant de regarder en dehors du manteau serait en fait confrontée à un miroir dans toutes les directions. En imaginant Harry Potter possédant une cape d'invisibilité fonctionnant de cette façon, et Harry allumant sa lampe torche pour s'éclairer, la lumière de celle-ci lui reviendrait droit dessus, quelle que soit la direction vers laquelle il la dirigerait.

L'équipe de Greenleaf s'est aperçu qu'un phénomène complexe surgissait lorsqu'on utilisait les équations de Maxwell, qui conduisait à un "blow up" (un comportement infini inattendu) des champs électromagnétiques. Mais les chercheurs ont découvert qu'en insérant des garnitures conductrices, dont les propriétés dépendent de la géométrie particulière du manteau, ce problème pouvait être résolu. Alternativement, recouvrir à la fois les surfaces intérieure et extérieure de la région masquée de matériaux soigneusement appropriés pouvait également permettre de résoudre ce problème.

"Nous devons également garder à l'esprit que, étant donné la technologie actuelle, lorsque nous parlons d'invisibilité, nous ne le faisons que pour une gamme étroite de longueurs d'onde", précise Greenleaf. "Par exemple, un objet pourrait être rendu invisible pour la longueur d'onde correspondant à la couleur rouge ; il serait visible pour pratiquement toutes les autres couleurs".

L'équipe de Smith à Duke travaille également à l'amélioration de son dispositif d'invisibilité. Le 6 décembre 2006, Smith et Greenleaf se sont réunis pour la première fois et ont discuté de ces nouvelles avancées mathématiques. "A. Greenleaf a étudié le problème beaucoup plus généralement, et en a déduit les conditions pour lesquelles l'invisibilité est réalisable ou non", déclare Smith. "Nous sommes très intéressés par ce que lui et son équipe apportent !"

Greenleaf et ses co-auteurs travaillent désormais à confirmer les correspondances entre leurs travaux et les expériences. Ils examinent les conséquences physiques du fait que certaines des équations n'ont pas de solution. Comme toute réalisation physique n'est qu'une approximation de l'idéal mathématique que son équipe analyse, Greenleaf indique qu'il serait également très intéressant de comprendre jusqu'à quel point de petites erreurs dans la construction effective dégradent l'effet de dissimulation.

Source: Université de Rochester

vendredi, décembre 29, 2006

lundi, décembre 04, 2006

Lancement industriel du futur Airbus: l'A350 XWB

Airbus a reçu vendredi le feu vert du Conseil d'Administration de sa maison mère, EADS, pour le lancement industriel de sa nouvelle famille de long-courriers de moyenne capacité au fuselage 'extra-large': l'A350 XWB. Le premier Airbus A350XWB sera mis en service en 2013.

Conçu pour devenir une famille d'avions de ligne complète, l'A350 XWB sera disponible en trois versions passagers de base. L'A350-800 pourra transporter 270 passagers dans une configuration tri-classe, sur des distances allant jusqu'à 15 750 km. L'A350-900 de 314 sièges, et l'A350-1000 qui est conçu pour recevoir 350 passagers, sont tous deux dotés d'une autonomie de 15 400 km. Ces trois versions passagers afficheront une vitesse de croisière de Mach 0.85. L'A350-900R aura une autonomie supérieure, la version cargo A350-900F viendra rejoindre les versions passagers de cette famille.

Selon ses dernières prévisions globales de marché (Global Market Forecast), Airbus estime la demande en avions passagers et avions cargos de cette catégorie au cours des 20 prochaines années à quelques 5 700 appareils, représentant 41% de la valeur totale des livraisons d'avions neufs de plus de 100 sièges.

Avec un diamètre de fuselage de 5,9 mètres, l'A350 XWB présentera le fuselage le plus large de sa catégorie. Il offrira également, selon Airbus, les coûts d'exploitation et les coûts au siège-kilomètre les plus bas de tous les appareils de cette catégorie.

L'A350 XWB sera équipé des réacteurs Trent XWB de Rolls-Royce de nouvelle génération, délivrant de 75 000 à 95 000 livres de poussée. L'appareil utilisera des panneaux de fuselage en CFRP (composites à base de fibres de carbone) entièrement nouveaux, plus légers et de maintenance améliorée. Cela doit faciliter la maintenance et la réparation des composants de la cellule, tout en permettant de mieux adapter la structure des panneaux aux charges locales de la structure. Plus de 60% de la structure sera fabriquée en nouveaux matériaux.

Source: Communiqué de presse EADS

Illustrations: Airbus

samedi, novembre 25, 2006

Eneco: une puce électronique transformant la chaleur en électricité

Récupérer la chaleur dégagée par les éléments électroniques pour la transformer en électricité: c'est ce que propose la société américaine Eneco, le système se présentant sous la forme d'un simple composant électronique.

La technologie est prometteuse, et intéresse déjà de grands fabricants de produits électroniques tels Apple et Dell. Ces derniers espèrent pouvoir ainsi augmenter l'autonomie de leurs ordinateurs portables tout en optimisant leur refroidissement et réduisant leur bruit. Le composant, de taille réduite et économique à produire puisque utilisant notamment des procédés de fabrication éprouvés, pourrait également être intégré dans les téléphones mobiles, les baladeurs, ou tout type d'appareils électroniques. L'équipe à la base de la création de ce composant pense qu'il serait également possible de l'intégrer directement dans les microprocesseurs.

L'efficacité annoncée est de 20 à 30%. Selon Eneco, la puissance électrique générée peut atteindre 10kW. Si le composant est lui-même alimenté en électricité, sa capacité en refroidissement se retrouve fortement augmentée. Les tests effectués par Eneco ont ainsi permis d'atteindre des températures de refroidissement de -150°C.

La puce utilise le principe physique de la thermoïonique, qui a pour conséquence la création d'un flux d'électrons dans un métal ou oxyde métallique. Ce phénomène s'établit lorsque les atomes de la matière possèdent une vibration causée par l'énergie thermique surpassant les forces électrostatiques maintenant en place son ou ses électrons libres. Plus la température est élevée, plus l'émission thermoïonique (le flux d'électrons généré) est importante.

La technologie, validée par le NIST (National Institute of Standards and Technology) qui a notamment confirmé les chiffres annoncés par Eneco, pourrait arriver sur le marché fin 2007 ou début 2008.

Source: Eneco et PCInpact.com

La technologie est prometteuse, et intéresse déjà de grands fabricants de produits électroniques tels Apple et Dell. Ces derniers espèrent pouvoir ainsi augmenter l'autonomie de leurs ordinateurs portables tout en optimisant leur refroidissement et réduisant leur bruit. Le composant, de taille réduite et économique à produire puisque utilisant notamment des procédés de fabrication éprouvés, pourrait également être intégré dans les téléphones mobiles, les baladeurs, ou tout type d'appareils électroniques. L'équipe à la base de la création de ce composant pense qu'il serait également possible de l'intégrer directement dans les microprocesseurs.

L'efficacité annoncée est de 20 à 30%. Selon Eneco, la puissance électrique générée peut atteindre 10kW. Si le composant est lui-même alimenté en électricité, sa capacité en refroidissement se retrouve fortement augmentée. Les tests effectués par Eneco ont ainsi permis d'atteindre des températures de refroidissement de -150°C.

La puce utilise le principe physique de la thermoïonique, qui a pour conséquence la création d'un flux d'électrons dans un métal ou oxyde métallique. Ce phénomène s'établit lorsque les atomes de la matière possèdent une vibration causée par l'énergie thermique surpassant les forces électrostatiques maintenant en place son ou ses électrons libres. Plus la température est élevée, plus l'émission thermoïonique (le flux d'électrons généré) est importante.

La technologie, validée par le NIST (National Institute of Standards and Technology) qui a notamment confirmé les chiffres annoncés par Eneco, pourrait arriver sur le marché fin 2007 ou début 2008.

Source: Eneco et PCInpact.com

Produire de l’hydrogène avec de l’eau sucrée

Des chercheurs de l’université du Minnesota à Minneapolis, ont réussi, en chauffant très rapidement de l’eau sucrée, à obtenir directement une décomposition en hydrogène et en monoxyde de carbone.

Ce nouveau processus présente deux avantages : il permet tout d’abord de s’affranchir des produits pétroliers pour produire "proprement" de l’hydrogène, le carburant de l’avenir pour la propulsion automobile ; deuxièmement, il peut s’appliquer à toute sorte de déchets végétaux... même au gazon coupé sortant des tondeuses.

Les chercheurs ont expérimenté leur procédé sur deux produits, l’huile de soja et l’eau sucrée. Ils ont vaporisé ces liquides en minuscules gouttelettes de 400 microns de diamètre en utilisant un simple injecteur d’essence provenant d’un moteur de voiture. La vapeur obtenue a été projetée sur un disque en céramique revêtu d’un catalyseur, un mélange de rhodium et de cérium. Au contact du disque poreux porté entre 800 0C et 1 000 0C, les gouttelettes se vaporisent en quelques millisecondes et se décomposent en monoxyde de carbone et en hydrogène.

Environ 70 % de l’hydrogène contenu dans l’huile est récupéré par aspiration de l’autre côté du disque. Caractéristique intéressante, la réaction chimique s’entretient elle-même : le disque en céramique doit être chauffé pour amorcer le processus, mais c’est ensuite la chaleur produite par la décomposition de l’huile qui le maintient à bonne température.

A l’aide du petit réacteur de 17 millimètres de diamètre utilisé, 500 grammes d’hydrogène sont produits par jour. D’après les calculs, un disque de 15 centimètres permettrait d’obtenir 3,7 litres d’hydrogène à l’heure.

Les chercheurs estiment que ce processus peut devenir une source de carburant pour les piles à combustibles lorsqu’elles seront au point. A plus court terme, le gaz synthétique est utilisable comme carburant dans les moteurs thermiques.

UM

Ce nouveau processus présente deux avantages : il permet tout d’abord de s’affranchir des produits pétroliers pour produire "proprement" de l’hydrogène, le carburant de l’avenir pour la propulsion automobile ; deuxièmement, il peut s’appliquer à toute sorte de déchets végétaux... même au gazon coupé sortant des tondeuses.

Les chercheurs ont expérimenté leur procédé sur deux produits, l’huile de soja et l’eau sucrée. Ils ont vaporisé ces liquides en minuscules gouttelettes de 400 microns de diamètre en utilisant un simple injecteur d’essence provenant d’un moteur de voiture. La vapeur obtenue a été projetée sur un disque en céramique revêtu d’un catalyseur, un mélange de rhodium et de cérium. Au contact du disque poreux porté entre 800 0C et 1 000 0C, les gouttelettes se vaporisent en quelques millisecondes et se décomposent en monoxyde de carbone et en hydrogène.

Environ 70 % de l’hydrogène contenu dans l’huile est récupéré par aspiration de l’autre côté du disque. Caractéristique intéressante, la réaction chimique s’entretient elle-même : le disque en céramique doit être chauffé pour amorcer le processus, mais c’est ensuite la chaleur produite par la décomposition de l’huile qui le maintient à bonne température.

A l’aide du petit réacteur de 17 millimètres de diamètre utilisé, 500 grammes d’hydrogène sont produits par jour. D’après les calculs, un disque de 15 centimètres permettrait d’obtenir 3,7 litres d’hydrogène à l’heure.

Les chercheurs estiment que ce processus peut devenir une source de carburant pour les piles à combustibles lorsqu’elles seront au point. A plus court terme, le gaz synthétique est utilisable comme carburant dans les moteurs thermiques.

UM

jeudi, novembre 23, 2006

Piratage des clés de cryptage en 'écoutant' le microprocesseur

Une équipe allemande de recherche en cryptographie dirigée par Jean Pierre Seifert a découvert une nouvelle technique d’attaque permettant de retrouver une clé de cryptage privée en quelques microsecondes.

Les algorithmes de cryptage asymétriques actuels reposent sur le fait qu’il est impossible mathématiquement parlant de retrouver une clé de cryptage privée en ne disposant que de la clé publique. Certaines techniques permettant de retrouver ses clés privées ont vu le jour ces dernières années, mais elles nécessitent une très importante capacité de calcul et beaucoup de temps.

La technique trouvée par l’équipe de Jean Pierre Seifert permet de retrouver cette clé de cryptage privée très rapidement. Le principe est assez simple : les microprocesseurs possèdent une capacité à prédire les résultats d’un calcul en cours afin de l’accélérer. Cette technologie n’étant pas sécurisée sur l’ensemble des processeurs du marché, l’équipe de Jean Pierre Seifert a mis au point un procédé permettant de déduire cette clé de cryptage en lisant directement les informations de prédiction de calcul générées par le microprocesseur.

Cette technique, encore gardée secrète par l’équipe de recherche sera dévoilée au prochain salon de la RSA (salon dédié à la sécurité informatique qui se déroulera les 5 et 7 février à San Francisco) et il y a fort à parier qu’il ne sera alors plus qu’une question de temps avant que les pirates ne s’en inspirent pour écrire des logiciels espions leur permettant de retrouver ces clés.

Même si la mise en œuvre d’un telle technique de piratage est loin d’être simple, les conséquences pourraient être désastreuses pour le commerce électronique qui se retrouverait alors avec des systèmes de protection de paiement en ligne totalement désuets.

La seule solution envisageable à ce jour serait de désactiver les fonctions de prédiction de résultat des microprocesseurs, ce qui ralentirait considérablement les performances de traitement de ces derniers. L’équipe de Jean Pierre Seifert travaille dorénavant à trouver une parade à cette nouvelle faille de sécurité.

A ce jour, Intel et AMD sont restés complètement muets à ce sujet.

source : THE INQUIRER

Les algorithmes de cryptage asymétriques actuels reposent sur le fait qu’il est impossible mathématiquement parlant de retrouver une clé de cryptage privée en ne disposant que de la clé publique. Certaines techniques permettant de retrouver ses clés privées ont vu le jour ces dernières années, mais elles nécessitent une très importante capacité de calcul et beaucoup de temps.

La technique trouvée par l’équipe de Jean Pierre Seifert permet de retrouver cette clé de cryptage privée très rapidement. Le principe est assez simple : les microprocesseurs possèdent une capacité à prédire les résultats d’un calcul en cours afin de l’accélérer. Cette technologie n’étant pas sécurisée sur l’ensemble des processeurs du marché, l’équipe de Jean Pierre Seifert a mis au point un procédé permettant de déduire cette clé de cryptage en lisant directement les informations de prédiction de calcul générées par le microprocesseur.

Cette technique, encore gardée secrète par l’équipe de recherche sera dévoilée au prochain salon de la RSA (salon dédié à la sécurité informatique qui se déroulera les 5 et 7 février à San Francisco) et il y a fort à parier qu’il ne sera alors plus qu’une question de temps avant que les pirates ne s’en inspirent pour écrire des logiciels espions leur permettant de retrouver ces clés.

Même si la mise en œuvre d’un telle technique de piratage est loin d’être simple, les conséquences pourraient être désastreuses pour le commerce électronique qui se retrouverait alors avec des systèmes de protection de paiement en ligne totalement désuets.

La seule solution envisageable à ce jour serait de désactiver les fonctions de prédiction de résultat des microprocesseurs, ce qui ralentirait considérablement les performances de traitement de ces derniers. L’équipe de Jean Pierre Seifert travaille dorénavant à trouver une parade à cette nouvelle faille de sécurité.

A ce jour, Intel et AMD sont restés complètement muets à ce sujet.

source : THE INQUIRER

samedi, novembre 04, 2006

< ASTUCE FIREFOX > Fichiers temporaires sous MAC OS

Vous avez remarqué que firefox enregistre tous les fichiers ouverts lors de la navigation sur le bureau, après une session de surf on se retrouve très vite avec le bureau envahi de PDF , DOC , JPEG et autres.

Il est impossible de modifier ce comportement via le menu préférence et il faut donc effacer ces fichiers temporaires un par un à la main...

Pour vous simplifier la vie voila une petite bidouille qui marche très bien :

tapez dans la barre d'adresse about:config

on entre par cette commande dans la config en mode expert

ensuite faire CTRL+ click et selectionner NOUVELLE et type BOOLEEN

dans le nom mettre browser.helperApps.deleteTempFileOnExit et comme valeur mettre VRAI

On force ainsi firefox a effecer tout les fichiers temporaires à la fermeture.

Il est impossible de modifier ce comportement via le menu préférence et il faut donc effacer ces fichiers temporaires un par un à la main...

Pour vous simplifier la vie voila une petite bidouille qui marche très bien :

tapez dans la barre d'adresse about:config

on entre par cette commande dans la config en mode expert

ensuite faire CTRL+ click et selectionner NOUVELLE et type BOOLEEN

dans le nom mettre browser.helperApps.deleteTempFileOnExit et comme valeur mettre VRAI

On force ainsi firefox a effecer tout les fichiers temporaires à la fermeture.

mardi, octobre 24, 2006

MetOp: mise sur orbite du nouvel observatoire météo européen

Un lanceur Soyouz a mis en orbite quasi-polaire ce 19 octobre 2006 MetOp-A, le premier satellite météorologique européen à opérer sur ce type d'orbite. Sa masse est de 4.082 kg, il a été lancé à partir du cosmodrome de Baïkonour au Kazakhstan. Il s'agit du premier satellite européen dédié à la surveillance du temps, du climat et de l'environnement.

Le satellite MetOp-A

MetOp-A est le premier exemplaire de la série. Initialement prévu en 2003, son lancement a été reporté plusieurs fois avant d'être fixé au 17 octobre 2006 au moyen d'une fusée Soyouz ST. Le satellite, comme les deux autres MetOp, est placé sur une orbite héliosynchrone quasi-polaire autour de la Terre à une altitude d'environ 840 km. Il fait le tour de la Terre quelques 14 fois par jour. Cette orbite est en mesure de couvrir certaines zones du globe comme les régions boréales et australes, ce que ne peut pas faire l'orbite géostationnaire, plus appropriée pour fournir une vision continue de la Terre. Les satellites MetOp fonctionneront en orbite au moins 5 ans et seront lancés sur 14 années.

Leurs 12 instruments fourniront des images à haute résolution des profils verticaux détaillés de température et d'humidité ainsi que la température de la surface des terres et des océans à l'échelle mondiale. Ils fourniront également des mesures des niveaux d'ozones dans l'atmosphère et surveilleront l'écoulement des vents au-dessus des océans.

Ces données fourniront des informations aux météorologues mais également aux scientifiques qui travaillent sur la problématique des changements climatiques qui affectent la Terre. On s'attend à de meilleures prévisions météorologiques et une surveillance climatique plus pertinente.

Note

Les satellites MetOp constitueront le secteur spatial du système polaire d'Eumetsat, composante européenne d'un système de satellites polaires météorologiques commun à l'Europe et aux Etats-Unis.

Avec ses MetOp qui assureront des services jusqu'en 2020, Eumetsat pourra désormais faire jeu égal avec la NOAA américaine (National Oceanic & Atmospheric Administation) qui gère les satellites météorologiques civils des USA. L'Europe sera chargée des observations de la matinée (9.30 a.m., heure locale), tandis que les USA continueront d'assurer les observations de l'après-midi (2.00 p.m.).

Dans le cadre de ce projet, l'Agence spatiale européenne est responsable du développement des satellites et du segment spatial. Quant à Eumetsat, qui fournit des instruments scientifiques, l'organisation sera en charge des opérations liées au lancement, du segment sol et des opérations de soutien pendant toute la durée de vie opérationnelle du satellite.

Source: flashespace.com

Illustrations: ESA - Silicon World & ESA- K. Büchler

lundi, octobre 16, 2006

Godson-2E: bientôt un processeur chinois dans nos ordinateurs ?

La Chine a annoncé la commercialisation de Longxin IIE (ou "Godson-2E"), son nouveau microprocesseur (CPU) 64 bit développé par l'Institut de technologie informatique de l'Académie des sciences à Pékin. Godson-2E est la nouvelle version d'une série de puces dont le développement a débuté en 2002.

Processeur Intel Pentium D. Bientôt un concurrent chinois ?

Dotée de 47 millions de transistors, soit plus que les 40 millions que contient le Pentium IV, sa capacité de calcul serait deux fois plus importante que celle de sa version précédente et sa consommation uniquement de trois à huit watts, ce qui en fait un processeur très économe aux performances annoncées proches de celles des processeurs américains mais qui pourrait être produit à des coûts bien plus faibles.

LI Guojie, directeur de l'Institut de technologie informatique, a déclaré que le nouveau microprocesseur avait déjà été inséré dans des ordinateurs à bas coût, diminuant ainsi leur prix de 50%. Le nom exact du processeur ainsi que son coût réel seront dévoilés dans les prochains mois.

La prochaine étape, d'après LI Guojie, est d'aboutir avant la fin de l'année à un processeur encore 30% plus performant et 50% plus économe que Godson-2E.

Source: Cette information est un extrait du BE Chine numéro 33 du 2/10/2006 rédigé par l'Ambassade de France en Chine. Les Bulletins Electroniques (BE) sont un service ADIT

Processeur Intel Pentium D. Bientôt un concurrent chinois ?

Dotée de 47 millions de transistors, soit plus que les 40 millions que contient le Pentium IV, sa capacité de calcul serait deux fois plus importante que celle de sa version précédente et sa consommation uniquement de trois à huit watts, ce qui en fait un processeur très économe aux performances annoncées proches de celles des processeurs américains mais qui pourrait être produit à des coûts bien plus faibles.

LI Guojie, directeur de l'Institut de technologie informatique, a déclaré que le nouveau microprocesseur avait déjà été inséré dans des ordinateurs à bas coût, diminuant ainsi leur prix de 50%. Le nom exact du processeur ainsi que son coût réel seront dévoilés dans les prochains mois.

La prochaine étape, d'après LI Guojie, est d'aboutir avant la fin de l'année à un processeur encore 30% plus performant et 50% plus économe que Godson-2E.

Source: Cette information est un extrait du BE Chine numéro 33 du 2/10/2006 rédigé par l'Ambassade de France en Chine. Les Bulletins Electroniques (BE) sont un service ADIT

mercredi, octobre 04, 2006

Du silicium moins cher pour les panneaux solaires

Selon la "Solar Energy Industries Association" (SEIA), le secteur du solaire photovoltaïque connaît depuis 5 ans une croissance annuelle de 30%, les constructeurs ont vendu en 2005 pour plus de 15 milliards de dollars de nouveaux produits à travers le monde. En raison de cette forte croissance, l'approvisionnement en silicium cristallin (silicium pur à 99.99999%), matériau de base des cellules solaires et également utilisé par l'industrie microélectronique, n'arrive plus à suivre les besoins du marché.

Dans le monde entier, il n'existe que quelques fabricants de silicium cristallin et leurs lignes de production sont déjà au maximum de leurs capacités. Lors d'une réunion, l'année dernière, du Conseil critique sur les matériaux, Sematech (association d'industries du semi-conducteur), les analystes ont prévu un manque de 6.000 tonnes de poly-silicium cette année, 12.000 tonnes en 2007, et 20.000 tonnes l'année suivante.

Les chercheurs de la compagnie Dow Corning viennent récemment d'annoncer qu'ils ont développé un matériau dérivé du silicium "métallurgique", qui peut être mélangé à du silicium poly-cristallin traditionnel de grande pureté pour fabriquer des cellules photovoltaïques de bonne qualité. Ce résultat pourrait permettre de faire face à la croissance de l'industrie photovoltaïque.

Grâce à l'utilisation du silicium "métallurgique", un matériau bien meilleur marché et pur à seulement 98%, la nouvelle technologie de Dow Corning a le potentiel de transformer de manière significative l'industrie photovoltaïque. Le silicium "métallurgique" est normalement employé dans les applications telles que le raffinage de l'acier, et comme ingrédient de base pour d'autres produits chimiques. La compagnie a l'intention d'accélérer fortement la production de ce nouveau type de silicium grâce à son usine située au Brésil à Santos Dumont.

Le matériau composite final possède selon Rudy Miller, Directeur marketing chez Dow Corning, les mêmes performances et caractéristiques de fabrication que celui utilisé traditionnellement avec l'avantage d'être significativement moins cher.

Source: Cette information est un extrait du BE Etats-Unis numéro 49 du 27/09/2006 rédigé par l'Ambassade de France aux Etats-Unis. Les Bulletins Electroniques (BE) sont un service ADIT et sont accessibles gratuitement sur www.bulletins-electroniques.com

Dans le monde entier, il n'existe que quelques fabricants de silicium cristallin et leurs lignes de production sont déjà au maximum de leurs capacités. Lors d'une réunion, l'année dernière, du Conseil critique sur les matériaux, Sematech (association d'industries du semi-conducteur), les analystes ont prévu un manque de 6.000 tonnes de poly-silicium cette année, 12.000 tonnes en 2007, et 20.000 tonnes l'année suivante.

Les chercheurs de la compagnie Dow Corning viennent récemment d'annoncer qu'ils ont développé un matériau dérivé du silicium "métallurgique", qui peut être mélangé à du silicium poly-cristallin traditionnel de grande pureté pour fabriquer des cellules photovoltaïques de bonne qualité. Ce résultat pourrait permettre de faire face à la croissance de l'industrie photovoltaïque.

Grâce à l'utilisation du silicium "métallurgique", un matériau bien meilleur marché et pur à seulement 98%, la nouvelle technologie de Dow Corning a le potentiel de transformer de manière significative l'industrie photovoltaïque. Le silicium "métallurgique" est normalement employé dans les applications telles que le raffinage de l'acier, et comme ingrédient de base pour d'autres produits chimiques. La compagnie a l'intention d'accélérer fortement la production de ce nouveau type de silicium grâce à son usine située au Brésil à Santos Dumont.

Le matériau composite final possède selon Rudy Miller, Directeur marketing chez Dow Corning, les mêmes performances et caractéristiques de fabrication que celui utilisé traditionnellement avec l'avantage d'être significativement moins cher.

Source: Cette information est un extrait du BE Etats-Unis numéro 49 du 27/09/2006 rédigé par l'Ambassade de France aux Etats-Unis. Les Bulletins Electroniques (BE) sont un service ADIT et sont accessibles gratuitement sur www.bulletins-electroniques.com

vendredi, juillet 14, 2006

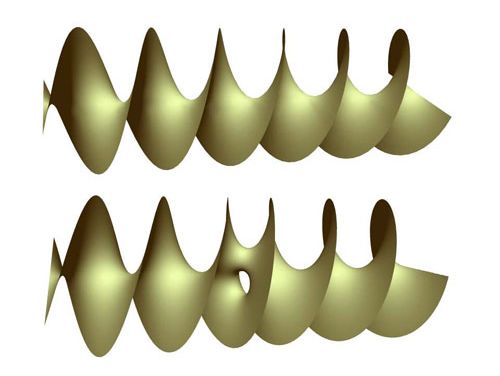

Un nouveau type d’éolienne à l’étude

La compagnie britannique Stormblade Turbine développe un nouveau type d’éolienne qui devrait être plus efficace, moins bruyante et nécessiter moins de maintenance que la formule standard à trois pales. L’un des problèmes les plus importants des éoliennes actuelles se produit lorsque la vitesse du vent est supérieure à 27 m/s (97 Km/h) : le rotor doit être arrêté, car un effet gyroscopique est alors créé dans l’arbre d’entraînement.

Cette précession gyroscopique (propriété d’un rotor par laquelle l’effet d’une force tendant à incliner l’axe du rotor est décalé de 90 degrés de son point d’application dans le sens de rotation) tend à tordre le rotor, ce qui augmente les contraintes sur les pales et les mécanismes, conduisant à des ruptures. Par ailleurs, si la vitesse du vent est inférieure à 7 m/s (24 km/h) la rotation du rotor est trop faible pour produire de l’électricité.

La Stormblade Turbine, créée par Victor Jovanovic, fondateur de la compagnie, a un design semblable à celui d’un réacteur d’avion : les pales sont protégées par un carénage qui dirige le flux d’air à l’intérieur de cette turbine comme une buse d’admission. Cependant, ce carénage est exposé au vent et aux vitesses de rotation élevées du flux d’air la traversant et peut développer ainsi un effet "parachute". Le mat de l’éolienne subit alors des contraintes extrêmes. Le mat doit alors être soutenu par un échafaudage renforcé, ce qui va nécessiter davantage de surface au sol et augmenter le coût du système.

L’innovation principale du système concerne donc la partie rotor qui est fondée sur la turbine d’un moteur à réaction. D’après M. Jovanovic : " les moteur à réaction ont évolué au cours des 50 dernières années afin de produire moins de traînées, permettant aux aubages de tourner plus rapidement". L’aérodynamique du système est donc améliorée ce qui permet de diminuer et d’augmenter la vitesse de rotation du rotor sans avoir à subir de phénomène de précession gyroscopique. L’efficacité de la Stormblade Turbine devrait être de 70 % contre 30-40 % pour les modèles actuels à trois pales, ce qui signifie que ce design dépasse la limite de Beltz (59 %) d’efficacité maximale pour les éoliennes. Jonanovic estime que son éolienne pourra produire de l’électricité pour une vitesse du vent comprise entre 3 m/s (11 Km/h) et 54 m/s (193 Km/h), doublant ainsi la plage de vitesse utilisable.

L’extension de la plage de vitesse offre deux avantages majeurs :

- la production d’électricité se fait de manière plus continue ;

- la puissance produite par ces éoliennes est très élevée : celle-ci est proportionnelle au cube de la vitesse du vent.

Comme les aubages sont à l’intérieur du carénage, le bruit provenant de la boite de vitesse devrait aussi être diminué. Cette configuration particulière permet, en outre, de diminuer les coûts de maintenance et de préserver la vie aviaire alentour. Au niveau de l’impact visuel, la surface de balayage de cette éolienne est inférieure à celle des éoliennes classiques. Les prototypes testés jusqu’à présent ont montré que l’efficacité du système est largement supérieure à celle des turbines existantes (jusqu’à 3 fois supérieure). La compagnie est actuellement à la recherche de fonds et de partenaires industriels. Ce système devrait être disponible sur le marché dans 18 mois à 2 ans.

source : BE GB

The Engineer RTFlash

Cette précession gyroscopique (propriété d’un rotor par laquelle l’effet d’une force tendant à incliner l’axe du rotor est décalé de 90 degrés de son point d’application dans le sens de rotation) tend à tordre le rotor, ce qui augmente les contraintes sur les pales et les mécanismes, conduisant à des ruptures. Par ailleurs, si la vitesse du vent est inférieure à 7 m/s (24 km/h) la rotation du rotor est trop faible pour produire de l’électricité.

La Stormblade Turbine, créée par Victor Jovanovic, fondateur de la compagnie, a un design semblable à celui d’un réacteur d’avion : les pales sont protégées par un carénage qui dirige le flux d’air à l’intérieur de cette turbine comme une buse d’admission. Cependant, ce carénage est exposé au vent et aux vitesses de rotation élevées du flux d’air la traversant et peut développer ainsi un effet "parachute". Le mat de l’éolienne subit alors des contraintes extrêmes. Le mat doit alors être soutenu par un échafaudage renforcé, ce qui va nécessiter davantage de surface au sol et augmenter le coût du système.

L’innovation principale du système concerne donc la partie rotor qui est fondée sur la turbine d’un moteur à réaction. D’après M. Jovanovic : " les moteur à réaction ont évolué au cours des 50 dernières années afin de produire moins de traînées, permettant aux aubages de tourner plus rapidement". L’aérodynamique du système est donc améliorée ce qui permet de diminuer et d’augmenter la vitesse de rotation du rotor sans avoir à subir de phénomène de précession gyroscopique. L’efficacité de la Stormblade Turbine devrait être de 70 % contre 30-40 % pour les modèles actuels à trois pales, ce qui signifie que ce design dépasse la limite de Beltz (59 %) d’efficacité maximale pour les éoliennes. Jonanovic estime que son éolienne pourra produire de l’électricité pour une vitesse du vent comprise entre 3 m/s (11 Km/h) et 54 m/s (193 Km/h), doublant ainsi la plage de vitesse utilisable.

L’extension de la plage de vitesse offre deux avantages majeurs :

- la production d’électricité se fait de manière plus continue ;

- la puissance produite par ces éoliennes est très élevée : celle-ci est proportionnelle au cube de la vitesse du vent.

Comme les aubages sont à l’intérieur du carénage, le bruit provenant de la boite de vitesse devrait aussi être diminué. Cette configuration particulière permet, en outre, de diminuer les coûts de maintenance et de préserver la vie aviaire alentour. Au niveau de l’impact visuel, la surface de balayage de cette éolienne est inférieure à celle des éoliennes classiques. Les prototypes testés jusqu’à présent ont montré que l’efficacité du système est largement supérieure à celle des turbines existantes (jusqu’à 3 fois supérieure). La compagnie est actuellement à la recherche de fonds et de partenaires industriels. Ce système devrait être disponible sur le marché dans 18 mois à 2 ans.

source : BE GB

The Engineer RTFlash

vendredi, juin 16, 2006

La Russie vise de nouveau la Lune

Trente ans après la dernière mission lunaire, Roskosmos vise de nouveau la Lune. L'agence spatiale russe planche sur une mission ambitieuse comprenant une dizaine de pénétrateurs et une petite station polaire. Cette annonce est rapportée par la revue américaine Aviation Week qui a mis en ligne un article des plus complets sur le déroulement de la mission.

Luna-Glob

La configuration de Luna-Glob (nom de la mission) comprend un orbiter, qui n'aurait pas d'autre fonction que de transporter la dizaine et de pénétrateurs et la station polaire autour de la Lune. Il y a aura deux types de pénétrateurs qui se différencieront par leur vitesse d'impact. Des 12 pénétrateurs de Luna-Glob, 10 seront plus rapides et s'enfonceront plus profondément sous la surface de la Lune. Les pénétrateurs seront répartis sur la surface lunaire de façon à former un réseau séismique. Deux viseront les sites d'atterrissages des missions Apollo 11 et 12, vraisemblablement pour corroborer les mesures des instruments déjà sur place, laissés par les astronautes américains en juillet et novembre 1969.

Quant à la station polaire (sorte de lander), elle sera déposée à l'intérieur d'un cratère situé au pôle sud. Son objectif étant de rechercher un dépôt significatif d'eau gelée. Cette station polaire doit également compléter les observations de Lunar Reconnaissance Orbiter. Cette sonde de la NASA, dont le lancement est prévu en 2008, doit notamment survoler les pôles lunaires et déterminer l'origine des traces de glace et d'hydrogène détectées par les missions précédentes.

Les scientifiques considèrent le Pôle sud comme un des meilleurs emplacements pour installer une première base. Cette région contient de l'eau et de l'hydrogène en abondance dans le sous-sol et les cratères lunaires, qui demeurent constamment à l'ombre du Soleil. Il est donc important de déterminer si de la glace d'eau peut être facilement exploitable. Sans quoi, l'installation de l'homme sur la Lune de façon durable sera très compliquée.

Molnya, le lanceur de Luna-Glob ?

Luna-Glob doit être lancé en 2012 au moyen d'une fusée Soyouz équipée d'un troisième étage nécessaire pour propulser sa charge utile au-delà de la vitesse de libération (11 km/s pour la Terre) et viser une orbite dite interplanétaire. Dans cette configuration, elle prend le nom de Molnya.

Source: flashespace.com

Luna-Glob

La configuration de Luna-Glob (nom de la mission) comprend un orbiter, qui n'aurait pas d'autre fonction que de transporter la dizaine et de pénétrateurs et la station polaire autour de la Lune. Il y a aura deux types de pénétrateurs qui se différencieront par leur vitesse d'impact. Des 12 pénétrateurs de Luna-Glob, 10 seront plus rapides et s'enfonceront plus profondément sous la surface de la Lune. Les pénétrateurs seront répartis sur la surface lunaire de façon à former un réseau séismique. Deux viseront les sites d'atterrissages des missions Apollo 11 et 12, vraisemblablement pour corroborer les mesures des instruments déjà sur place, laissés par les astronautes américains en juillet et novembre 1969.

Quant à la station polaire (sorte de lander), elle sera déposée à l'intérieur d'un cratère situé au pôle sud. Son objectif étant de rechercher un dépôt significatif d'eau gelée. Cette station polaire doit également compléter les observations de Lunar Reconnaissance Orbiter. Cette sonde de la NASA, dont le lancement est prévu en 2008, doit notamment survoler les pôles lunaires et déterminer l'origine des traces de glace et d'hydrogène détectées par les missions précédentes.

Les scientifiques considèrent le Pôle sud comme un des meilleurs emplacements pour installer une première base. Cette région contient de l'eau et de l'hydrogène en abondance dans le sous-sol et les cratères lunaires, qui demeurent constamment à l'ombre du Soleil. Il est donc important de déterminer si de la glace d'eau peut être facilement exploitable. Sans quoi, l'installation de l'homme sur la Lune de façon durable sera très compliquée.

Molnya, le lanceur de Luna-Glob ?

Luna-Glob doit être lancé en 2012 au moyen d'une fusée Soyouz équipée d'un troisième étage nécessaire pour propulser sa charge utile au-delà de la vitesse de libération (11 km/s pour la Terre) et viser une orbite dite interplanétaire. Dans cette configuration, elle prend le nom de Molnya.

Source: flashespace.com

jeudi, juin 15, 2006

Produire de l'électricité à partir de la chaleur ambiante

Des chercheurs de la School of Electronic and Computer Science de l'Université de Southampton vont essayer de mettre au point des microgénérateurs produisant de l'électricité à partir de la chaleur ambiante. Ce projet de trois ans, financé par le gouvernement, a pour but de créer des alternatives aux batteries pour des systèmes électroniques miniatures.

Ces microgénérateurs thermoélectriques utilisent la différence de température entre deux métaux connectés pour produire de l'électricité (effet Seebeck). D'après le professeur Neil White, chef du projet, ces systèmes sont extrêmement fiables et ont une longue durée de vie. Cependant, les générateurs thermoélectriques existants sont inefficaces et trop encombrants pour alimenter des capteurs portables. Les chercheurs vont donc utiliser des techniques avancées de micro-usinage pour créer une nouvelle génération de microgénérateurs sur un substrat au silicium. La puissance fournie par ces systèmes devrait être de l'ordre de quelques milliwatts ce qui est suffisant pour alimenter des microprocesseurs et émettre des signaux de fréquence radio.

Ce projet va tout d'abord s'intéresser à des applications où la source de chaleur est l'Homme, pouvant aboutir à des applications médicales (appareils de mesures miniatures) et sportives (indicateurs de performance). Vu la présence croissante de systèmes électroniques miniatures pour toutes sortes d'applications, ces systèmes thermoélectriques, légers, fiables et à longue durée de vie peuvent fournir une alternative économiquement intéressante aux batteries et autres câbles d'alimentation tout en utilisant une source d'énergie renouvelable.

Source: Cette information est un extrait du BE Royaume-Uni numéro 67 du 8/06/2006 rédigé par l'Ambassade de France au Royaume-Uni.

Ces microgénérateurs thermoélectriques utilisent la différence de température entre deux métaux connectés pour produire de l'électricité (effet Seebeck). D'après le professeur Neil White, chef du projet, ces systèmes sont extrêmement fiables et ont une longue durée de vie. Cependant, les générateurs thermoélectriques existants sont inefficaces et trop encombrants pour alimenter des capteurs portables. Les chercheurs vont donc utiliser des techniques avancées de micro-usinage pour créer une nouvelle génération de microgénérateurs sur un substrat au silicium. La puissance fournie par ces systèmes devrait être de l'ordre de quelques milliwatts ce qui est suffisant pour alimenter des microprocesseurs et émettre des signaux de fréquence radio.

Ce projet va tout d'abord s'intéresser à des applications où la source de chaleur est l'Homme, pouvant aboutir à des applications médicales (appareils de mesures miniatures) et sportives (indicateurs de performance). Vu la présence croissante de systèmes électroniques miniatures pour toutes sortes d'applications, ces systèmes thermoélectriques, légers, fiables et à longue durée de vie peuvent fournir une alternative économiquement intéressante aux batteries et autres câbles d'alimentation tout en utilisant une source d'énergie renouvelable.

Source: Cette information est un extrait du BE Royaume-Uni numéro 67 du 8/06/2006 rédigé par l'Ambassade de France au Royaume-Uni.

Produire de l'électricité à partir de la chaleur ambiante

Des chercheurs de la School of Electronic and Computer Science de l'Université de Southampton vont essayer de mettre au point des microgénérateurs produisant de l'électricité à partir de la chaleur ambiante. Ce projet de trois ans, financé par le gouvernement, a pour but de créer des alternatives aux batteries pour des systèmes électroniques miniatures.

Ces microgénérateurs thermoélectriques utilisent la différence de température entre deux métaux connectés pour produire de l'électricité (effet Seebeck). D'après le professeur Neil White, chef du projet, ces systèmes sont extrêmement fiables et ont une longue durée de vie. Cependant, les générateurs thermoélectriques existants sont inefficaces et trop encombrants pour alimenter des capteurs portables. Les chercheurs vont donc utiliser des techniques avancées de micro-usinage pour créer une nouvelle génération de microgénérateurs sur un substrat au silicium. La puissance fournie par ces systèmes devrait être de l'ordre de quelques milliwatts ce qui est suffisant pour alimenter des microprocesseurs et émettre des signaux de fréquence radio.

Ce projet va tout d'abord s'intéresser à des applications où la source de chaleur est l'Homme, pouvant aboutir à des applications médicales (appareils de mesures miniatures) et sportives (indicateurs de performance). Vu la présence croissante de systèmes électroniques miniatures pour toutes sortes d'applications, ces systèmes thermoélectriques, légers, fiables et à longue durée de vie peuvent fournir une alternative économiquement intéressante aux batteries et autres câbles d'alimentation tout en utilisant une source d'énergie renouvelable.

Source: Cette information est un extrait du BE Royaume-Uni numéro 67 du 8/06/2006 rédigé par l'Ambassade de France au Royaume-Uni.

Ces microgénérateurs thermoélectriques utilisent la différence de température entre deux métaux connectés pour produire de l'électricité (effet Seebeck). D'après le professeur Neil White, chef du projet, ces systèmes sont extrêmement fiables et ont une longue durée de vie. Cependant, les générateurs thermoélectriques existants sont inefficaces et trop encombrants pour alimenter des capteurs portables. Les chercheurs vont donc utiliser des techniques avancées de micro-usinage pour créer une nouvelle génération de microgénérateurs sur un substrat au silicium. La puissance fournie par ces systèmes devrait être de l'ordre de quelques milliwatts ce qui est suffisant pour alimenter des microprocesseurs et émettre des signaux de fréquence radio.

Ce projet va tout d'abord s'intéresser à des applications où la source de chaleur est l'Homme, pouvant aboutir à des applications médicales (appareils de mesures miniatures) et sportives (indicateurs de performance). Vu la présence croissante de systèmes électroniques miniatures pour toutes sortes d'applications, ces systèmes thermoélectriques, légers, fiables et à longue durée de vie peuvent fournir une alternative économiquement intéressante aux batteries et autres câbles d'alimentation tout en utilisant une source d'énergie renouvelable.

Source: Cette information est un extrait du BE Royaume-Uni numéro 67 du 8/06/2006 rédigé par l'Ambassade de France au Royaume-Uni.

mercredi, juin 14, 2006

Des physiciens génèrent un champ gravitationnel artificiel

Une masse en rotation, ici un trou noir, entraîne l'espace-temps

Le Département de propulsion spatiale d'Austrian Research Centers Seiberdorf (ARCS), en Autriche, pense avoir généré un champ gravitationnel en mettant en rotation un anneau supraconducteur

Martin Tajmar, directeur de ce département, a tiré parti de l'effet Lense-Thirring (ou effet d'entraînement des référentiels), prédit par les physiciens autrichiens Hans Thirring et Joseph Lense en 1918: des masses en rotation entraînent l'espace-temps les entourant, en créant un champ gravitationnel additionnel, ce qu'ont confirmé des mesures des trajectoires de satellites effectuées en 2004. Ainsi, des forces gravitationnelles significatives peuvent être produites sans rassembler d'énormes masses.

Par ailleurs, des expériences menées sur des disques supraconducteurs en rotation indiquaient que les paires d'électrons de Cooper les parcourant avaient des masses inattendues, supérieures à celles prédites par la mécanique quantique. La gravitation y était-elle modifiée ? De nouvelles expériences, financées par la NASA et l'ESA, paraissent le confirmer: un anneau en niobium de 15 cm de diamètre, refroidi à -264°C et tournant à 6.500 tours/minutes, crée un champ gravito-magnétique, d'une intensité 1.000.000 de fois inférieure à celle du champ gravitationnel terrestre, mais de 25 à 30 ordres de grandeur supérieure à celle attendue.

Source: Cette information est un extrait du BE Autriche numéro 84 du 5/06/2006 rédigé par l'Ambassade de France en Autriche

dimanche, juin 11, 2006

Flaviir: un avion (drone) sans pilote et sans volets de direction

Des chercheurs britanniques annoncent que leur projet d'avion sans pilote et sans volets de direction devrait être prêt en 2009. Cet avion est développé dans le cadre du programme de cinq ans FLAVIIR (Flapless Air Vehicle Integrated Industrial Research), financé par l'Engineering and Physical Sciences Research Council (EPSRC) et BAE Systems à hauteur de 6,2 millions de livres (environ 9 millions d'euros).

Ce projet est composé d'équipes des universités de Leicester, Liverpool, Nottingham, Southampton, Swansea, Warwick, York et Londres ; le Goldstein Aeronautical Research Laboratory de l'Université de Machester a développé un modèle réduit et l'ensemble du programme est dirigé par l'Université de Cranfield. Son but est de créer de nouvelles technologies pour la prochaine génération d'avions sans pilote (drones).

Pour la partie mécanique du projet, c'est-à-dire un avion sans volets ni ailerons de direction, la technologie du fluidic thrust vectoring (FTV) est fortement envisagée. Elle consiste en la déviation du flux d'air principal par frottement avec un flux secondaire. Cette technologie est généralement incorporée dans les tuyères de réacteur à l'aide de mécanismes rotatifs ou d'ailettes afin de dévier une partie du flux. Les technologies de jets d'air, à savoir le soufflage d'air sur le bord de fuite de l'aile, pourraient aussi remplacer les ailerons de direction conventionnels.

La partie logicielle, qui consiste à remplacer le pilote, est principalement effectuée par l'Université de Leicester. En 2005, cette équipe a développé un progiciel pour la planification du plan de vol. Ce progiciel comprend plusieurs méthodes de planification et est capable d'opérer en temps réel et de réagir à certains imprévus. Actuellement les chercheurs se concentrent principalement sur l'automatisation des systèmes mécaniques avancés pour la direction tels le FTV et les jets d'air. Un système d'analyse d'état de l'appareil est prévu: des séries de capteurs situées sur la cellule de l'avion sont à l'étude.

Une autre partie du projet consiste en l'étude de mécanismes de détection d'incidents afin de créer un système tolérant aux pannes afin de conserver des performances de vol adéquates en cas de problèmes.

Les résultats des différentes équipes de recherche, composées d' experts en aérodynamique, automatique, électromagnétisme, production, matériaux et structure, et simulation numérique, devraient être rassemblés en un seul prototype de démonstration en 2009.

Source: Cette information est un extrait du BE Royaume-Uni numéro 66 du 5/05/2006 rédigé par l'Ambassade de France au Royaume-Uni.

mercredi, juin 07, 2006

Vers le tissage des ailes d'avion ?

Les universités d'Ulster, Nottingham et Bristol, en partenariat avec les compagnies Rolls-Royce, Dowty Propellors, Advanced Composite Group, Deep Sea Engineering et Stigmatex, travaillent sur l'étude du tissage des matériaux pour la fabrication de composants d'avions de nouvelle génération.

Ce projet est financé en partie par le Department of Trade and Industry (DTI, ministère du Commerce et de l'Industrie) qui va fournir les outils informatiques pour la création et le test virtuel de ces matériaux tissés.

Les fibres de carbone sont actuellement très utilisées dans l'industrie aérospatiale, généralement sous forme stratifiées: les couches du matériau sont imprégnées de résine (époxy) et ensuite placées les unes sur les autres afin d'obtenir les propriétés recherchées. Ce matériau multicouche est ensuite chauffé sous pression pour former le composite requis. Ici, le but est de tisser ces fibres pour obtenir des formes en 3 dimensions et injecter ensuite directement la résine sous vide ou par imprégnation de la résine sous forme de film. Le durcissement de la pièce se fait par chauffage en cuve pressurisée.

Ce procédé de tissage devrait permettre d'obtenir des composites de haute performance avec directement l'épaisseur et la forme souhaitées. Cependant, les motifs impliqués sont très complexes, ils nécessitent les techniques de l'industrie textile, créant ainsi une relation entre les deux industries.

Le but de cette étude est de mieux comprendre l'influence des techniques de tissage sur les propriétés des composites. Ceux-ci pourraient ensuite être utilisés pour des composants de structure des ailes et des moteurs. Les chercheurs pensent que ces composites tissés ont le potentiel d'être plus légers et plus robustes que les métaux traditionnels, ce qui signifie que ces avions consommeraient moins de carburant, voleraient plus vite pour de plus longues distances et seraient plus rapides à fabriquer.

Source: Cette information est un extrait du BE Royaume-Uni numéro 66 du 5/05/2006 rédigé par l'Ambassade de France au Royaume-Uni. Les Bulletins Electroniques (BE) sont un service ADIT et sont accessibles gratuitement sur www.bulletins-electroniques.com

Ce projet est financé en partie par le Department of Trade and Industry (DTI, ministère du Commerce et de l'Industrie) qui va fournir les outils informatiques pour la création et le test virtuel de ces matériaux tissés.

Les fibres de carbone sont actuellement très utilisées dans l'industrie aérospatiale, généralement sous forme stratifiées: les couches du matériau sont imprégnées de résine (époxy) et ensuite placées les unes sur les autres afin d'obtenir les propriétés recherchées. Ce matériau multicouche est ensuite chauffé sous pression pour former le composite requis. Ici, le but est de tisser ces fibres pour obtenir des formes en 3 dimensions et injecter ensuite directement la résine sous vide ou par imprégnation de la résine sous forme de film. Le durcissement de la pièce se fait par chauffage en cuve pressurisée.

Ce procédé de tissage devrait permettre d'obtenir des composites de haute performance avec directement l'épaisseur et la forme souhaitées. Cependant, les motifs impliqués sont très complexes, ils nécessitent les techniques de l'industrie textile, créant ainsi une relation entre les deux industries.

Le but de cette étude est de mieux comprendre l'influence des techniques de tissage sur les propriétés des composites. Ceux-ci pourraient ensuite être utilisés pour des composants de structure des ailes et des moteurs. Les chercheurs pensent que ces composites tissés ont le potentiel d'être plus légers et plus robustes que les métaux traditionnels, ce qui signifie que ces avions consommeraient moins de carburant, voleraient plus vite pour de plus longues distances et seraient plus rapides à fabriquer.

Source: Cette information est un extrait du BE Royaume-Uni numéro 66 du 5/05/2006 rédigé par l'Ambassade de France au Royaume-Uni. Les Bulletins Electroniques (BE) sont un service ADIT et sont accessibles gratuitement sur www.bulletins-electroniques.com

mardi, juin 06, 2006

Minatec: important centre européen de recherche sur les nanotechnologies

Le Minatec, le plus important centre de recherche en Europe sur les nanotechnologies, vient d'être inauguré à Grenoble. Le centre s'étend sur une superficie de 45.000 mètres carrés et doit accueillir environ 4.000 chercheurs, ingénieurs, techniciens et étudiants.

Le but du Minatec est de réunir les différents acteurs des nanotechnologies sur un même pôle. Comme l'explique Jean-Charles Guibert, directeur de la valorisation au Commissariat à l'énergie atomique (CEA), "les industriels ne pouvaient plus passer leur temps pour aller d'une ville à l'autre, d'un labo à l'autre pour trouver ce dont ils ont besoin au niveau innovation".

Les principaux axes de recherche seront la microélectronique, les nanosciences, les technologies de l'information (logiciels) et les biotechnologies. L'investissement s'élève à un total de 170 millions d'euros. Seuls deux centres dans le monde peuvent rivaliser avec le nouveau pôle, Nanotec aux Etats-Unis et Selete au Japon.

De l'écran ultra-plat enroulable au téléphone portable intégré dans les vêtements, en passant par les matériaux à base de nanotubes de carbonnes, le Minatec étudiera des applications du domaine des microtechonlogies (de l'ordre du millième de millimètre) et nanotechnologies (de l'ordre du millionième de millimètre) dont le grand public pourra bénéficier sur une échéance de 5 à 10 ans.

source : techno science

Le but du Minatec est de réunir les différents acteurs des nanotechnologies sur un même pôle. Comme l'explique Jean-Charles Guibert, directeur de la valorisation au Commissariat à l'énergie atomique (CEA), "les industriels ne pouvaient plus passer leur temps pour aller d'une ville à l'autre, d'un labo à l'autre pour trouver ce dont ils ont besoin au niveau innovation".

Les principaux axes de recherche seront la microélectronique, les nanosciences, les technologies de l'information (logiciels) et les biotechnologies. L'investissement s'élève à un total de 170 millions d'euros. Seuls deux centres dans le monde peuvent rivaliser avec le nouveau pôle, Nanotec aux Etats-Unis et Selete au Japon.

De l'écran ultra-plat enroulable au téléphone portable intégré dans les vêtements, en passant par les matériaux à base de nanotubes de carbonnes, le Minatec étudiera des applications du domaine des microtechonlogies (de l'ordre du millième de millimètre) et nanotechnologies (de l'ordre du millionième de millimètre) dont le grand public pourra bénéficier sur une échéance de 5 à 10 ans.

source : techno science

jeudi, juin 01, 2006

Repérer automatiquement les failles de sécurité des sites Internet

L'Université technique de Vienne a conçu un programme capable de repérer automatiquement les failles de sécurité des sites internet.

Le logiciel, dénommé SecuBat Framework, agit comme le ferait un pirate informatique: il attaque les sites web dynamiques afin d'identifier les forces et faiblesses de leurs systèmes de sécurité. Il les sollicite par des attaques croisées XSS (Cross-Site Scripting Attacks) ou par des injections SQL, c'est-à-dire en insérant des scripts Javascript ou des fragments de code SQL dans leurs formulaires, pour interroger leurs bases de données ou modifier leurs pages.

SecuBat est composé d'un crawler multi-processus (qui parcourt toute l'arborescence d'un site web pour en lister les pages), de modules d'attaque (qui s'en prennent à celles d'entre elles contenant des formulaires) et d'un module d'analyse (pour la compilation et la visualisation des résultats).

D'après les premiers essais, menés sur près de 20.000 adresses web, 6,63% des applications Internet sont vulnérables à des injections SQL, 4,30% à des attaques XSS simples et 5,60% à des attaques XSS encodées. Les sites gouvernementaux et les sites de commerce électronique ne sont pas épargnés.

Source: Cette information est un extrait du BE Autriche numéro 83 du 12/05/2006 rédigé par l'Ambassade de France en Autriche. Les Bulletins Electroniques (BE) sont un service ADIT et sont accessibles gratuitement sur www.bulletins-electroniques.com

Le logiciel, dénommé SecuBat Framework, agit comme le ferait un pirate informatique: il attaque les sites web dynamiques afin d'identifier les forces et faiblesses de leurs systèmes de sécurité. Il les sollicite par des attaques croisées XSS (Cross-Site Scripting Attacks) ou par des injections SQL, c'est-à-dire en insérant des scripts Javascript ou des fragments de code SQL dans leurs formulaires, pour interroger leurs bases de données ou modifier leurs pages.

SecuBat est composé d'un crawler multi-processus (qui parcourt toute l'arborescence d'un site web pour en lister les pages), de modules d'attaque (qui s'en prennent à celles d'entre elles contenant des formulaires) et d'un module d'analyse (pour la compilation et la visualisation des résultats).

D'après les premiers essais, menés sur près de 20.000 adresses web, 6,63% des applications Internet sont vulnérables à des injections SQL, 4,30% à des attaques XSS simples et 5,60% à des attaques XSS encodées. Les sites gouvernementaux et les sites de commerce électronique ne sont pas épargnés.

Source: Cette information est un extrait du BE Autriche numéro 83 du 12/05/2006 rédigé par l'Ambassade de France en Autriche. Les Bulletins Electroniques (BE) sont un service ADIT et sont accessibles gratuitement sur www.bulletins-electroniques.com

mercredi, mai 31, 2006

Une peinture 'nano' pour bloquer les appels de téléphones portables

NaturalNano, compagnie américaine basée à Rochester NY, propose une solution innovante pour se débarrasser définitivement des sonneries de téléphone portable à l'intérieur d'une pièce ou d'un bâtiment. La solution tient dans un pot de peinture qui contient des additifs inhabituels: des nanoparticules de cuivre contenues dans des nanotubes.

Les particules métalliques écrantent les signaux radiofréquences reçus et émis par les téléphones portables. A l'intérieur d'une pièce aux murs couverts de cette peinture aucune communication radiofréquence n'est possible avec l'extérieur. Cette technologie est beaucoup plus simple et moins chère à mettre en oeuvre que l'utilisation de matériaux de construction spéciaux pour le blindage électromagnétique.

Pour faciliter l'incorporation du cuivre dans la peinture, NaturalNano utilise des nanotubes dits 'halloy' composés d'un mélange d'aluminium, de silicium, d'hydrogène et d'oxygène que l'on trouve à l'état naturel dans certains gisements miniers. Leur diamètre varie de 40 à 200nm et leur longueur de 500nm à 1.2µm. La compagnie a signé un accord commercial avec une société minière pour se procurer ces nanotubes naturels dont elle étudie les propriétés et les applications.

NaturalNano a récemment breveté un système permettant de contrôler l'activation du bouclier électromagnétique et le filtrage des signaux afin de pouvoir transmettre sélectivement les appels d'urgence. La technologie pourrait être utilisée dans les salles de concerts, les salles de cinéma, les églises, les salles de classe... etc.

Source: Cette information est un extrait du BE Etats-Unis numéro 25 du 9/03/2006 rédigé par l'Ambassade de France aux Etats-Unis.

Les particules métalliques écrantent les signaux radiofréquences reçus et émis par les téléphones portables. A l'intérieur d'une pièce aux murs couverts de cette peinture aucune communication radiofréquence n'est possible avec l'extérieur. Cette technologie est beaucoup plus simple et moins chère à mettre en oeuvre que l'utilisation de matériaux de construction spéciaux pour le blindage électromagnétique.

Pour faciliter l'incorporation du cuivre dans la peinture, NaturalNano utilise des nanotubes dits 'halloy' composés d'un mélange d'aluminium, de silicium, d'hydrogène et d'oxygène que l'on trouve à l'état naturel dans certains gisements miniers. Leur diamètre varie de 40 à 200nm et leur longueur de 500nm à 1.2µm. La compagnie a signé un accord commercial avec une société minière pour se procurer ces nanotubes naturels dont elle étudie les propriétés et les applications.

NaturalNano a récemment breveté un système permettant de contrôler l'activation du bouclier électromagnétique et le filtrage des signaux afin de pouvoir transmettre sélectivement les appels d'urgence. La technologie pourrait être utilisée dans les salles de concerts, les salles de cinéma, les églises, les salles de classe... etc.

Source: Cette information est un extrait du BE Etats-Unis numéro 25 du 9/03/2006 rédigé par l'Ambassade de France aux Etats-Unis.

dimanche, mai 28, 2006

Vidéo du lancement du satellite CALIPSO

Le lanceur Delta II, a parfaitement réussi sa mission et mis sur orbite héliosynchrone les satellites CALIPSO et CLOUDSAT, le 28 avril 2006, depuis la base américaine de Vandenberg.

vous pouvez revivre le lancement en vidéo en cliquant sur le lien suivant :

http://mediaarchive.ksc.nasa.gov/detail.cfm?mediaid=28546

Vers la conception d'un système d'invisibilité

Des chercheurs américains et britanniques ont dévoilé un modèle théorique décrivant un dispositif d'invisibilité. Jusqu'ici l'invisibilité était réservée à la science fiction, utilisée pour des vaisseaux spatiaux de la série Stargate, de la franchise Star Trek ou encore pour la cape utilisée par Harry Potter. Un démonstrateur pourrait voir le jour dans 18 mois.

Deux équipes scientifiques décrivent, dans un article qui vient de paraître dans la revue Science, la théorie permettant de masquer les objets. Le principal défi reste l'élaboration de "métamatériaux" qui pourraient permettre de dévier les ondes électromagnétiques, telles que la lumière.

L'invisibilité serait créée par une distorsion des rayons lumineux, qui verraient leur trajectoire s'incurver afin de contourner l'objet à masquer. Les rayons prennent ensuite, derrière l'objet, la trajectoire qu'ils auraient eu si l'objet n'avait pas été là. Comme l'explique le professeur Pendry, de l'Imperial College à Londres, c'est semblable à un petit obstacle au milieu d'un cours d'eau: l'eau contourne l'obstacle et le courant "normal" se reforme dès que l'obstacle est franchi. Le travail effectué par les chercheurs fournit une "recette" mathématique permettant d'incurver les rayons afin de réaliser l'effet de dissimulation désiré.

John Pendry, et ses collègues américains David Smith et David Schurig du Duke University en Caroline du nord, ont examiné des métamatériaux appropriés pour réaliser un dispositif d'invisibilité. Il s'agirait d'une sphère ou d'un cylindre enveloppé dans une gaine permettant de masquer des ondes radio. Un premier modèle de démonstration est prévu pour dans 18 mois.

Cette étude pourrait avoir des utilisations en technologie militaire de furtivité, pouvant par exemple permettre de masquer un avion ou un tank. Les recherches du professeur Pendry sont soutenues par la DARPA américaine (Defense Advanced Research Projects Agency).

Source: BBC

Illustration: D. Schurig, Duke University

samedi, mai 27, 2006

Internet du futur: 107 Gbit/s pour une puce de décodage de données

Des chercheurs de Siemens, en collaboration avec des spécialistes d'Infineon, ont développé un récepteur qui décode très rapidement les données d'Internet issues des fibres optiques en signaux électriques. Pour recevoir de tels signaux, des superstructures très complexes et coûteuses étaient jusqu'ici nécessaires. Les éléments utilisés pour la première fois dans cette puce Infineon sont essentiels pour améliorer et augmenter l'efficacité des réseaux de transmission à l'avenir.

Pour que le transport de données des réseaux de télécommunication ne soit pas saturé, les entrepreneurs doivent développer de nouvelles lignes de transmission plus performantes (avec, de préférence, un prix plus attractif). De nouveaux éléments High-tech avantageux sont actuellement élaborés dans le cadre du projet de coopération "prototype pour un récepteur direct de 80Gbit/s muni d'un démultiplexeur".

Ce projet est mené par Siemens Corporate Technology (CT) et Communications (Com) à Munich en collaboration avec Infineon Technologies et est financé par le Ministère fédéral de l'enseignement et de la recherche (BMBF). Le récepteur conçu grâce à cette nouvelle technologie peut actuellement traiter des données avec une vitesse de 107 Gbit/s (107 Gbits correspondant aux données de 2 DVD).

Source: Cette information est un extrait du BE Allemagne numéro 286 du 17/05/2006 rédigé par l'Ambassade de France en Allemagne. Les Bulletins Electroniques (BE) sont un service ADIT et sont accessibles gratuitement sur www.bulletins-electroniques.com

Illustration: Siemens

Pour que le transport de données des réseaux de télécommunication ne soit pas saturé, les entrepreneurs doivent développer de nouvelles lignes de transmission plus performantes (avec, de préférence, un prix plus attractif). De nouveaux éléments High-tech avantageux sont actuellement élaborés dans le cadre du projet de coopération "prototype pour un récepteur direct de 80Gbit/s muni d'un démultiplexeur".

Ce projet est mené par Siemens Corporate Technology (CT) et Communications (Com) à Munich en collaboration avec Infineon Technologies et est financé par le Ministère fédéral de l'enseignement et de la recherche (BMBF). Le récepteur conçu grâce à cette nouvelle technologie peut actuellement traiter des données avec une vitesse de 107 Gbit/s (107 Gbits correspondant aux données de 2 DVD).

Source: Cette information est un extrait du BE Allemagne numéro 286 du 17/05/2006 rédigé par l'Ambassade de France en Allemagne. Les Bulletins Electroniques (BE) sont un service ADIT et sont accessibles gratuitement sur www.bulletins-electroniques.com

Illustration: Siemens

dimanche, mai 14, 2006

Du plastique à partir de maniocs ou de pommes de terre

Deux découvertes récentes montrent qu'il est possible de produire un plastique biodégradable à partir de tubercules, comme le manioc ou encore la pomme de terre.

Dans le premier cas, des chercheurs japonais et indonésiens ont travaillé à partir de manioc Manihot esculenta, qui est la deuxième culture la plus répandue en Indonésie après le riz. Jusqu'à présent, les tentatives pour tirer un matériau plastique de cette plante furent des échecs, en raison de la quantité importante d'eau contenue dans le manioc, et sa tendance à pourrir rapidement. Un partenariat entre l'Université d'Agriculture et de Technologie de Tokyo et l'Agence Indonésienne des Technologies Appliquées a permis de remédier à ces problèmes. Les racines de manioc sont moulues puis incorporées dans une solution où une enzyme produit de l'acide lactique. L'acide lactique va être ensuite récupéré puis chauffé afin de produire un plastique biodégradable.

Mais la pomme de terre Solanum tuberosum peut aussi servir à la fabrication de matières plastiques. Une équipe de l'Université de Tokyo, menée par le professeur Hiroaki SHIMADA, a réussi à synthétiser du polyhydroxybutyrate (PHB) dans une pomme de terre, à la suite d'une manipulation génétique.

Le PHB est un polymère appartenant à la famille des polyesters; il est produit naturellement par de nombreux micro-organismes. Le PHB possède des propriétés physiques très intéressantes, similaires à celle du polypropylène (haut point de fusion...), et il est rapidement biodégradable. Ses deux points faibles sont sa fragilité et son coût de production élevé dû au fait que l'on est obligé de passer par une synthèse bactérienne.

Les chercheurs ont donc extrait les gènes d'une bactérie productrice de PHB. L'équipe avait déjà réussi à exprimer ces gènes dans Arabidopsis thaliana (ou Arabette des dames) lors d'une expérience précédente. Cette fois-ci, ils sont parvenus à faire produire du PHB par la pomme de terre. Pour le moment, on retrouve environ 10 microgrammes de PHB par gramme de pomme de terre. Les chercheurs estiment que si ils parviennent à franchir le seuil des 150 microgrammes par gramme, la culture de plants de pomme de terre génétiquement modifiés pourra concurrencer la culture bactérienne classique.

Du fait de sa fragilité et de sa biodégrabilité, le PHB peut être utilisé dans l'industrie alimentaire, mais aussi comme "Drug Delivery System" (ou DDS) ou comme support de reconstruction tissulaire.

Source: Cette information est un extrait du BE Japon numéro 403 du 10/05/2006 rédigé par l'Ambassade de France au Japon.

Dans le premier cas, des chercheurs japonais et indonésiens ont travaillé à partir de manioc Manihot esculenta, qui est la deuxième culture la plus répandue en Indonésie après le riz. Jusqu'à présent, les tentatives pour tirer un matériau plastique de cette plante furent des échecs, en raison de la quantité importante d'eau contenue dans le manioc, et sa tendance à pourrir rapidement. Un partenariat entre l'Université d'Agriculture et de Technologie de Tokyo et l'Agence Indonésienne des Technologies Appliquées a permis de remédier à ces problèmes. Les racines de manioc sont moulues puis incorporées dans une solution où une enzyme produit de l'acide lactique. L'acide lactique va être ensuite récupéré puis chauffé afin de produire un plastique biodégradable.

Mais la pomme de terre Solanum tuberosum peut aussi servir à la fabrication de matières plastiques. Une équipe de l'Université de Tokyo, menée par le professeur Hiroaki SHIMADA, a réussi à synthétiser du polyhydroxybutyrate (PHB) dans une pomme de terre, à la suite d'une manipulation génétique.

Le PHB est un polymère appartenant à la famille des polyesters; il est produit naturellement par de nombreux micro-organismes. Le PHB possède des propriétés physiques très intéressantes, similaires à celle du polypropylène (haut point de fusion...), et il est rapidement biodégradable. Ses deux points faibles sont sa fragilité et son coût de production élevé dû au fait que l'on est obligé de passer par une synthèse bactérienne.

Les chercheurs ont donc extrait les gènes d'une bactérie productrice de PHB. L'équipe avait déjà réussi à exprimer ces gènes dans Arabidopsis thaliana (ou Arabette des dames) lors d'une expérience précédente. Cette fois-ci, ils sont parvenus à faire produire du PHB par la pomme de terre. Pour le moment, on retrouve environ 10 microgrammes de PHB par gramme de pomme de terre. Les chercheurs estiment que si ils parviennent à franchir le seuil des 150 microgrammes par gramme, la culture de plants de pomme de terre génétiquement modifiés pourra concurrencer la culture bactérienne classique.

Du fait de sa fragilité et de sa biodégrabilité, le PHB peut être utilisé dans l'industrie alimentaire, mais aussi comme "Drug Delivery System" (ou DDS) ou comme support de reconstruction tissulaire.

Source: Cette information est un extrait du BE Japon numéro 403 du 10/05/2006 rédigé par l'Ambassade de France au Japon.

jeudi, avril 20, 2006

Lancement du satellite

Le lancement de Calipso aura lieu Vendredi 21 Avril à 12h00 ( heure de toulouse) vous pouvez suivre le lancement sur ce site : http://www.nasa.gov/mission_pages/calipso/launch/event-cloud-calipso.html

jeudi, avril 13, 2006

Moteur à explosion: le laser remplace les bougies

Malgré des progrès constants, le moteur à combustion interne fait encore très "vingtième siècle". Pour vraiment entrer dans le troisième millénaire, quoi de mieux que d'y ajouter un laser? C'est ce qu'est en train de mettre au point une équipe de l'Université du Colorado, qui a déposé un brevet pour le remplacement des bougies par des pulsations de laser via une fibre optique spéciale qui dirige le faisceau dans les cylindres.

L'utilisation du laser a plusieurs avantages par rapport aux bougies classiques: meilleur contrôle du positionnement et de l'intensité, ce qui permet une meilleure combustion, et bien sûr pas d'usure ni d'encrassage.

Le problème jusqu'à présent était de fabriquer une fibre qui supporte le niveau d'intensité du laser nécessaire à cet usage. Le brevet déposé porte sur la composition de cette nouvelle fibre, en verre et remplie d'hélium, qui pour l'instant permet de déclencher la combustion dans un moteur fonctionnant au gaz naturel. Mais les chercheurs espèrent bien pouvoir rapidement appliquer la technologie aux autres types de carburant.

Source: Le Blog Auto sous Licence Creative Commons by-sa

mercredi, avril 12, 2006

Mise en orbite réussie pour Venus Express

lundi, avril 10, 2006

Free lance le WiMAX: Internet et téléphonie mobiles illimités ?

Free profite de sa licence WiMAX (fixe norme - 802.16d) obtenue lors de l'acquisition d'Altitude Telecom (voir notre news) pour annoncer le lancement prochain d'une offre d'expérimentation pour tous ses abonnés afin de tester le service WiMAX.

Pour profiter du WiMAX, les abonnés devront s'équiper de matériel spécial (émanant de la société israëlienne Alvarion, spécialiste du WiMAX) compatible avec le réseau IFW. IFW (anciennement Altitude Telecom) est une filiale d'Iliad, la maison mère de Free, spécialisée dans la BLR (Boucle Locale Radio). Le WiMAX est une technologie de type BLR. Le réseau d'IFW est déployé dans toutes les régions de la France métropolitaine, dont l'Ile de France, la Basse-Normandie et la Haute-Normandie. Une évolution vers le WiMAX mobile (norme 802.16e) du matériel d'Alvarion est prévue lorsque celle-ci sera normalisée et certifiée. Il faudra être à portée des stations WiMAX d'IFW, déployées depuis deux ans, afin de profiter de l'accès WiMAX.

Free est le deuxième opérateur Internet haut débit en France, avec 1,6 million d'abonnés fin 2005, loin derrière Wanadoo (France Telecom) avec ses 7,4 millions de clients fin 2005 (dont 4,5 millions en France). Rappelons que Free est la seule société a posséder une licence WiMAX nationale en France, mais cela devrait changer rapidement, car une procédure d'attribution de licences régionales est en cours. Neuf Cegetel et France Telecom viennent par ailleurs de lancer une contestation auprès du Conseil d'Etat au sujet de la licence WiMAX obtenue par l'acquisition d'Altitude Telecom.

On peut penser que la technologie WiMAX permettra à Free de proposer un téléphone portable hybride compatible GSM/Wi-Fi/WiMAX à ses abonnés, à l'image du BeautifulPhone de Neuf Cegetel Quand sera-t-il alors de la 3G ?

Source: CanardWifi sous Licence Creative Commons by-nc